Aujourd’hui je vous propose un billet léger et pas très intéressant, pour vous divertir un petit peu.

A chaque fois qu’un visiteur arrive dans nos bureaux des ix-labs, il y a quelques commentaires incontournables. Le premier est généralement : « ils sont grands ces bureaux, et ils sont top », ce qui est vrai pour le premier point, et un plaisir à entendre pour le deuxième. Ensuite on a le droit à « wow, vous avez une sacré bibliothèque », et puis ensuite il y a un léger silence, remplacé par un « je suis sur que TON bureau c’est celui avec tout le bordel^^ » quand le visiteur me connait bien. Est-ce vrai ? On va dire oui et non, je vous laisse juge^^ :

Alors oui, le rangement n’est pas mon fort, mais tout ce qui est sur mon bureau est indispensable, et je vais vous en faire la liste incomplète, et aussi vous parler ainsi de certaines choses importantes pour bien bosser.

- Un ordinateur. Quelle surprise, je suis dans l’informatique et j’ai un ordinateur… Mon choix s’est porté sur un mac, grand écran et assez puissant. Il y a toujours des discussions sans fin à ce sujet, mais c’est pour moi un bon compromis : il y a toutes les fonctionnalités d’une machine sous linux (ligne de commande, serveur X, emacs, etc.), une interface graphique ergonomique et tous les outils de développement modernes. Perso je fais principalement du R, du Python et du latex, donc tout est OK. Par ailleurs, la suite office fonctionne très bien sur le mac, ce qui me permet d’être compatible avec les rageux sous Windows.

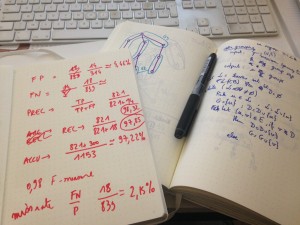

- Des cahiers, plein de cahiers. Au moment où j’écris ces lignes j’ai 12 cahiers différents sur mon bureau !

Mes cahiers préférés j’en parlerais dans un billet spécial un jour, mais j’utilise surtout des cahiers leuchtturm A5. C’est un peu comme des moleskine, mais en beaucoup mieux (si vous voulez en acheter pour Noël, passez donc par ma version en affiliation amazon

Mes cahiers préférés j’en parlerais dans un billet spécial un jour, mais j’utilise surtout des cahiers leuchtturm A5. C’est un peu comme des moleskine, mais en beaucoup mieux (si vous voulez en acheter pour Noël, passez donc par ma version en affiliation amazon).

J’aime aussi beaucoup les SOS Notes d’Oxford, si ils étaient en A5 plutôt qu’A4 ce serait encore mieux (lien amazon).

Chaque cahier son utilité : un pour un gros projet, un pour plusieurs petits projets, un pour les idées, un pour les lectures, etc. Travailler sur un cahier plutôt qu’à l’écran est fondamental car cela libère la créativité. Si vous utilisez un outil textuel logiciel pour noter vos idées, vous ne ferez pas de schémas, vous aurez une pensée linéaire et pauvre, et oui j’exagère un peu pour faire passer mon idée.

- Des stylos de toutes les couleurs. Si il y a des cahiers, il faut des stylos. J’ai des plumes jetables de toutes les couleurs, un roller Dupont offert par un client (ahah, si des clients passent par là, n’hésitez pas), un beau plume offert par ma douce, des feutres, des crayons, etc. J’utilise plein de couleurs pour mettre en évidence les choses importantes, et pour faire des schémas « temporels » (en noir ce qui reste stable, en rose l’évolution au temps 1, en vert au temps 2, en … etc.).

- Des lunettes. Bon, de base je suis déjà myope et astigmate, donc j’ai des lunettes. Comme je suis coquet j’ai des belles lunettes pour sortir et tout, mais j’ai toujours eu en plus une paire supplémentaire au bureau. Cette paire avait jusqu’ici comme fonctionnalité d’être à ma vue et d’être plus légère que l’autre.

Mais après avoir discuté avec mon pote Julien qui fait du SEO pour Clearly, j’ai appris l’existence de lunettes avec un traitement anti-fatigue pour ceux qui travaillent devant un écran toute la journée.

J’ai honteusement soudoyé Julien et j’ai donc obtenu une paire (celle de la photo) et je dois bien dire que j’ai été surpris : ça change vraiment la vie de bosser avec ces lunettes. En revanche, je ne m’en sers pas en dehors du bureau car le traitement modifie légèrement les couleurs. Si vous êtes au Canada, jetez donc un coup d’oeil au site de lunettes de Clearly (peut-être qu’on peux acheter depuis la France aussi, je ne sais pas).

J’ai honteusement soudoyé Julien et j’ai donc obtenu une paire (celle de la photo) et je dois bien dire que j’ai été surpris : ça change vraiment la vie de bosser avec ces lunettes. En revanche, je ne m’en sers pas en dehors du bureau car le traitement modifie légèrement les couleurs. Si vous êtes au Canada, jetez donc un coup d’oeil au site de lunettes de Clearly (peut-être qu’on peux acheter depuis la France aussi, je ne sais pas).

- Un casque audio. Je ne suis pas tout seul dans le bureau, et pour une raison que j’ignore mes compagnons de bureau ne partage pas mes goûts pour l’eurodance et la makina. J’ai donc un casque. J’en ai testé (comprendre cassé) pas mal, comme le Parrot Zik qui a survécu 3 mois… Au final les casques anti-bruit sont rangés et je les sors pour prendre l’avion, et je suis parti sur du robuste pour le bureau.

Le casque qui me sert désormais est mon casque de running : le Trainer de chez Gibson (bluetooth uniquement, lien amazon). Il tient parfaitement (normal on peut courir avec), il est étanche (croyez moi sur mon bureau c’est un plus) et sans fil ce qui fait que quand je me lève je n’emmène pas avec moi l’ordinateur…

Le casque qui me sert désormais est mon casque de running : le Trainer de chez Gibson (bluetooth uniquement, lien amazon). Il tient parfaitement (normal on peut courir avec), il est étanche (croyez moi sur mon bureau c’est un plus) et sans fil ce qui fait que quand je me lève je n’emmène pas avec moi l’ordinateur…

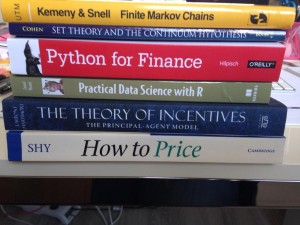

- Des livres. Qu’est ce qui est mieux qu’un livre ? DEUX livres ! Bref, en ce moment sur mon bureau il y a « Python for finance », « Practical data science with R » (bouquin vraiment au top, lien sur amazon

), « statistiques avec R » et « doing data science ».

Pourquoi des livres en vrai papier ? Parce que ça se lit partout, parce qu’on peut ECRIRE dessus. Un livre c’est fait pour vivre et donc on peut annoter ses livres, on peut les lire n’importe où, et on peut le laisser dans le bureau pour les petits camarades, alors que si le bouquin est sur la tablette, c’est plus compliqué.

Pourquoi des livres en vrai papier ? Parce que ça se lit partout, parce qu’on peut ECRIRE dessus. Un livre c’est fait pour vivre et donc on peut annoter ses livres, on peut les lire n’importe où, et on peut le laisser dans le bureau pour les petits camarades, alors que si le bouquin est sur la tablette, c’est plus compliqué.

Voilà, c’était mon billet plus léger du moment, n’hésitez pas à me dire comment sont vos bureaux dans les commentaires ^^